Da es langsam zur Gewohnheit wird defekte Festplatten zu tauschen, weil diese heute schneller den Geist aufgeben denn je, eine kleine Gedächtnisstütze für mich. Gehen wir davon aus sdb hat den Abgang gemacht. Operieren am offenen Herzen, also im laufenden Betrieb, am Software Raid mittels mdadm.

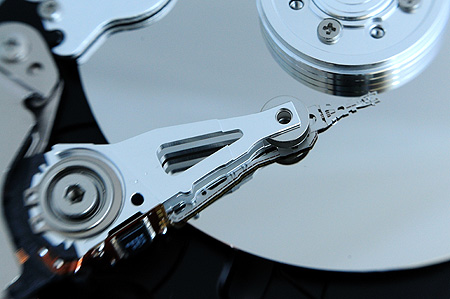

Was waren das doch Zeiten mit den 15.000ern SCSI Platten. Die liefen heute noch, hätte ich sie jetzt nicht aufgemacht um Fotos der Steinalt-Computertechnik zu machen. Übrigens ist auf dem Foto, man sieht es sicherlich ganz deutlich, der erste zaghafte Anfang meiner Selbstständigkeit abgebildet. Die Platte kommt aus meinem ersten Eigenbau-Linux-Server, der mit Software-Raid und Samba in einer Windows Umgebung lief und zeitweise zuvor sogar noch im Kinder-Computerzimmer mit ISDN Schnittstelle den ISDN Verkehr, und als Router den Internetverkehr lenkte. 4,3 GB Investition in die Zukunft. 😀

Egal, jetzt geht es darum, dass die Webserver laufen. 1&1 verbaut bei mir Seagate Barracuda Festplatten.

# hwinfo --disk Model: "ST3500630AS" Device: "ST3500630AS"

Leistungstechnisch jetzt nicht gerade eine Rakete, aber OK. Schlimmer ist, dass mir jetzt in einem halben Jahr drei Stück von den Teilen abgeraucht sind, eine davon überlebte die 4-Wochen Frist nicht. Also los gehts:

1.) Defekte Festplatte aus dem Raid Verbund lösen:

# mdadm -r /dev/md1 /dev/sdb1 # mdadm -r /dev/md5 /dev/sdb5 ...

2.) Schauen ob die Festplatte auch weg ist:

# cat /proc/mdstat

Personalities : [linear] [raid0] [raid1] [raid10] [raid6] [raid5] [raid4] [faulty]

md1 : active raid1 sda1[0]

9775424 blocks [2/1] [U_]

md5 : active raid1 sda5[0]

9775424 blocks [2/1] [U_]

md6 : active raid1 sda6[0]

9775424 blocks [2/1] [U_]

md7 : active raid1 sda7[0]

457097344 blocks [2/1] [U_]

unused devices: <none>3.) Neue Festplatte einbauen (lassen)

4.) Partitionierung von sda auf sdb kopieren

# sfdisk -d /dev/sda | sfdisk /dev/sdb

5.) Partitionstabelle kontrollieren

#sfdisk -l /dev/sdb Disk /dev/sdb: 60801 cylinders, 255 heads, 63 sectors/track Units = cylinders of 8225280 bytes, blocks of 1024 bytes, counting from 0 Device Boot Start End #cyls #blocks Id System /dev/sdb1 0+ 1216 1217- 9775521 fd Linux raid autodetect /dev/sdb2 1217 1460 244 1959930 82 Linux swap / Solaris /dev/sdb4 1461 60800 59340 476648550 5 Extended /dev/sdb5 1461+ 2677 1217- 9775521 fd Linux raid autodetect /dev/sdb6 2678+ 3894 1217- 9775521 fd Linux raid autodetect /dev/sdb7 3895+ 60800 56906- 457097413+ fd Linux raid autodetect

6.) sdb Patitionen wieder ins Raid einhängen

# mdadm -a /dev/md1 /dev/sdb1 # mdadm -a /dev/md5 /dev/sdb5 ...

7.) Warten bis das Raid wieder synchron ist, Status überprüfen

# cat /proc/mdstat

Personalities : [linear] [raid0] [raid1] [raid10] [raid6] [raid5] [raid4] [faulty]

md1 : active raid1 sda1[0] sdb1[0]

9775424 blocks [2/2] [UU]

md5 : active raid1 sda5[0] sdb5[0]

9775424 blocks [2/2] [UU]

md6 : active raid1 sda6[0] sdb6[0]

9775424 blocks [2/2] [UU]

md7 : active raid1 sda7[0] sdb7[0]

457097344 blocks [2/2] [U_]

[======>..............] recovery = 24.6% (112445947/457097344) finish=67.4min speed=91751K/sec

unused devices: <none>8.) Bootloader wieder installieren

# grub grub> device (hd0) /dev/sda grub> root (hd0,0) grub> setup (hd0) grub> device (hd1) /dev/sdb grub> root (hd1,0) grub> setup (hd1) grub> quit

9.) Swap Bereich aktivieren

#makeswap /dev/sdb2 #swapon -a

10.) Erstmal über die neue Festplatte freuen

11.) Endlich daran denken die Festplatten zu überwachen

#./mdadm --monitor --mail=me@localhost --syslog --delay=3600 /dev/md0 --daemonise

Mein Erfahrungen: Festplatten geben besonders gerne in RAID-Systemen den Löffel ab. Warum? Weil die Plattenlieferanten ihre Firmware beim Kunden reifen lassen.